فناوری سوئیچ نوری در دیتاسنتر و تفاوت آن با سوئیچهای سنتی

در عصر رشد سریع داده و نیاز به ارتباطات با سرعت بسیار بالا، فناوریهای سنتی شبکه با محدودیتهای ذاتی خود روبهرو شدهاند. یکی از مهمترین نوآوریهای چند سال اخیر، ظهور سوئیچهای نوری (Optical Switches) است؛ دستگاههایی که به جای سیگنالهای الکتریکی از نور برای انتقال داده استفاده میکنند.

سوئیچ نوری چیست؟

سوئیچ نوری یک تجهیز شبکه است که بهجای عبور الکترونها از مدارهای مسی، از فوتونها در فیبر نوری برای انتقال داده استفاده میکند. این روش باعث افزایش سرعت، کاهش تأخیر و کاهش مصرف انرژی میشود. در دیتاسنترهای بزرگ، جایی که میلیاردها بسته داده در ثانیه جابهجا میشود، این بهبودها تأثیر قابلتوجهی دارند.

تفاوت سوئیچ نوری با سوئیچهای سنتی

سوئیچهای سنتی یا همان الکترونیکی (Electrical Switches) از پردازندهها و مدارهای سیلیکونی برای مسیریابی داده استفاده میکنند. اما این فرآیند نیازمند تبدیل مداوم سیگنال بین نور و برق است — که علاوه بر مصرف انرژی بالا، تأخیر نیز ایجاد میکند.

در مقابل، سوئیچهای نوری مسیر داده را بهصورت مستقیم و با نور منتقل میکنند. به بیان ساده، هیچ مرحلهای از تبدیل الکترونیکی در مسیر وجود ندارد و داده با سرعت نزدیک به نور حرکت میکند.

| ویژگی | سوئیچ نوری | سوئیچ الکترونیکی |

| روش انتقال داده | نور (فوتون) | الکترون |

| سرعت انتقال | بسیار بالا (ترابیت بر ثانیه) | محدود به فرکانس پردازنده |

| مصرف انرژی | کمتر تا ۴۰٪ | بیشتر |

| تأخیر (Latency) | بسیار پایین | متوسط تا بالا |

| هزینه اولیه | بالا | کمتر |

| مقیاسپذیری | بسیار بالا | محدود |

چرا دیتاسنترها به سمت سوئیچهای نوری حرکت میکنند؟

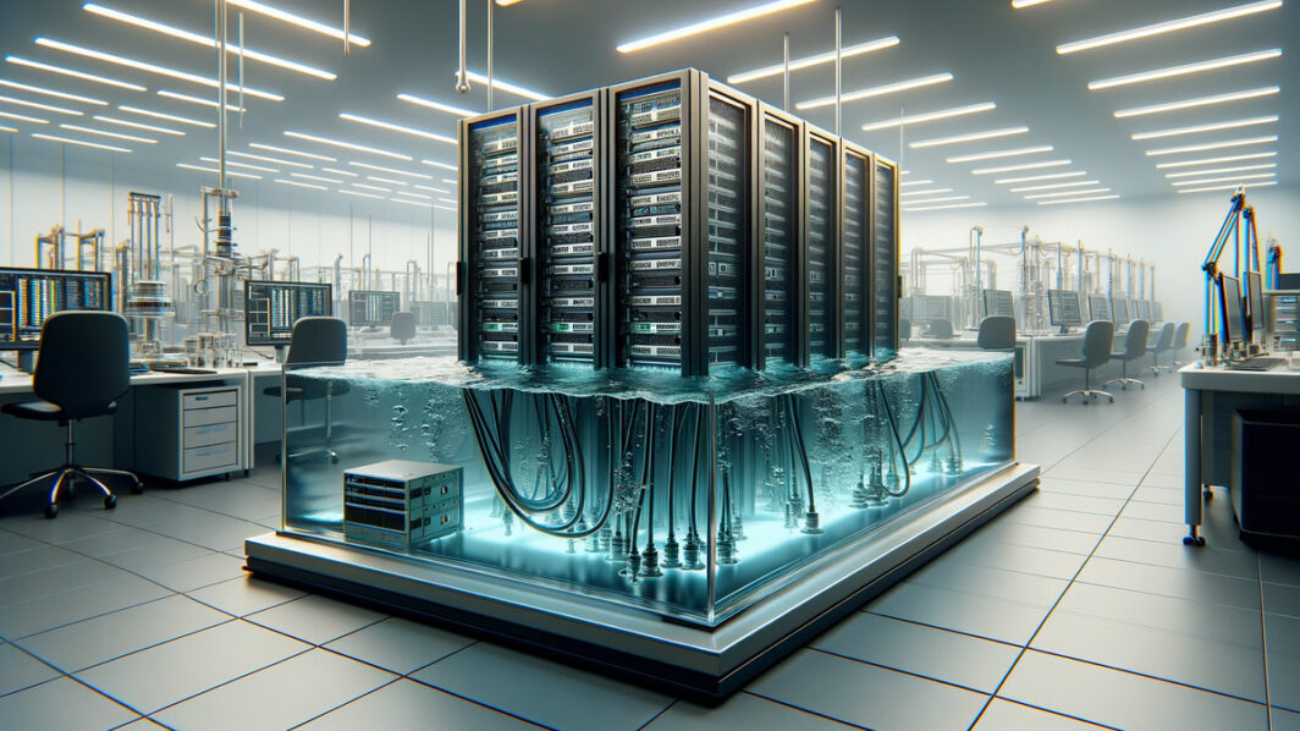

با افزایش حجم پردازشهای هوش مصنوعی، ویدیو و کلود، انتقال سریع داده میان رکها حیاتی است. سوئیچهای نوری به دیتاسنترها اجازه میدهند تا هزاران سرور را بدون ایجاد گلوگاه ارتباطی به هم متصل کنند. علاوه بر این، گرمای تولیدی کمتری دارند و نیاز به سرمایش را کاهش میدهند.

چالشهای پیادهسازی

هزینه تولید و نگهداری بالا، نیاز به تنظیم دقیق مسیرهای نوری و استانداردسازی اتصالات از مهمترین چالشها هستند. با این حال، پیشرفت فناوری در حوزه فوتونیک و کاهش قیمت فیبر نوری باعث شده این فناوری بهسرعت در مسیر تجاری شدن قرار گیرد.

آینده سوئیچینگ نوری در دیتاسنترها

پیشبینیها نشان میدهد که تا سال ۲۰۲۷ بیش از ۳۰٪ از دیتاسنترهای بزرگ جهان از سوئیچ نوری یا هیبریدی (Optical-Electronic Hybrid) استفاده خواهند کرد. این ترکیب، بهترین تعادل بین کارایی و هزینه را فراهم میکند.

بهطور خلاصه، سوئیچهای نوری مسیر آینده ارتباطات پرسرعت در مراکز داده هستند — زیرساختی که بهطور مستقیم بر سرعت پردازش، مصرف انرژی و پایداری محیطی تأثیر میگذارد.

© بازنویسی اختصاصی برای سانا سیستم راشا – نسخه فارسی تحلیلی جهت آموزش و اطلاعرسانی.

اشتراک گذاری در تلگرام

اشتراک گذاری در واتساپ